2

0

2618

В конце ноября 2022 года пользователи интернета получили доступ к ChatGPT – чат-боту компании OpenAI. Созданный на основе так называемой "большой языковой модели" бот, с одной стороны, способен писать стихи, компьютерные программы, копировать литературные стили разных авторов, готовить эссе на практически любую тему, переводить на разные языки и поддерживать связную беседу, с другой – нередко ошибается в самых простых вопросах. Но это, как и другие подобные системы искусственного интеллекта (ИИ), не игрушка, а технология, которая сильно изменит наш мир.

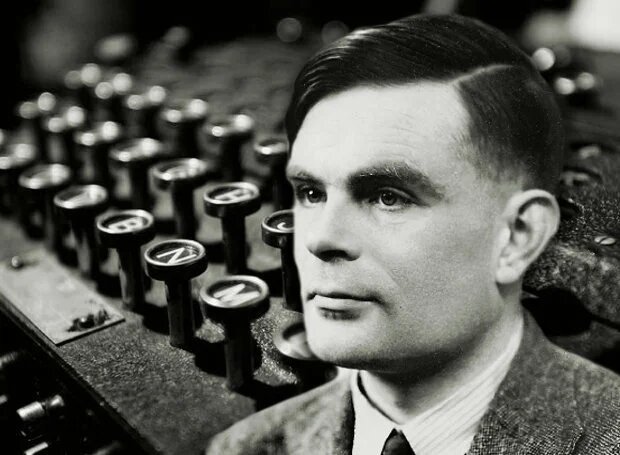

ChatGPT, пожалуй, первый искусственный интеллект, способный пройти тест Тьюринга: если не знать заранее, что общаешься с ботом, его реплики в беседе можно принять за человеческие. Это качество британский математик Алан Тьюринг предложил в своей работе 1950 года считать критерием "думающей машины". До искуственных интеллектов из фантастических романов, обладающих личностью и сознанием, еще далеко, но теперь и они не кажутся сказкой.

Специалист в области теории вычислительных машин Скотт Ааронсон считает, что благодаря развитию ChatGPT и других аналогичных систем мир оказался на пороге революционных перемен, но заключаться они будут не в появлении роботов с человеческим уровнем разума, а в новом взаимодействии с информацией. Перемены, сравнимые с теми, которые произошли после изобретения интернет-браузера, не обязательно пойдут человечеству только во благо. Среди самых очевидных рисков взрывного роста способностей ИИ – появление инструментов колоссальной мощности для мошенников и пропагандистов. Специально для того, чтобы оценить угрозы, связанные с ChatGPT и другими ИИ, и придумать способы бороться с ними, Скотта Ааронсона пригласили провести год в компании OpenAI.

В интервью Радио Свобода Ааронсон рассказал о силе и слабости ChatGPT, о том, обретет ли ИИ сознание и почему важно уметь различать человеческую и искусственную речь.

Спящий мозг

– Я опасаюсь таких выражений, как "научный прорыв" или "революция в технологиях", такие вещи происходят крайне редко, но...

– Но все-таки происходят. Если успех больших языковых моделей в последние пару лет – это не прорыв, то я не знаю, что можно назвать прорывом.

– Итак, предстоит ли нам в ближайшее время увидеть настоящий, правильнее сказать, сильный искусственный интеллект, нечто, обладающее сознанием?

– Это, конечно, вопрос определения. В некотором смысле мы его уже видим. У нас есть ИИ, который способен более или менее разумно вести беседу на любую тему. То, чего мы добились, – а этого никто не мог предсказать еще каких-то 10 лет назад, – мы построили величайшего актера импровизации. Он способен сыграть любую роль, он одновременно все и никто. Вы можете попросить ChatGPT сыграть Человека-паука, и он это сделает, а потом вы перезагрузите страницу в браузере, и бот забудет о том, кем он был, и будет готов примерить другую личность. Но способность сохранять единую личность? Взаимодействовать с физическим миром? Ставить и достигать цели? Иметь убеждения, укорененные в опыте? Ничего этого у ChatGPT, конечно, нет. Но в смысле определения Тьюринга это уже "думающая машина".

– Кстати, проводил ли кто-нибудь с ChatGPT классический тест Тьюринга?

– Если честно, я не знаю. Но все эти курсовые, которые студенты по всему миру создают с помощью бота и которые их преподаватели не могут отличить от написанного человеком текста, – это ведь уже в каком-то смысле успешный тест Тьюринга.

– Что насчет самосознания? Смогут ли большие языковые модели развиться настолько, что обретут его? Или это в принципе невозможно, по аргументу китайской комнаты?

– Проблема с сознанием в том, что о нем сложно рассуждать эмпирически. Вы не можете опытным путем выяснить, обладает ли что-то сознанием или нет, собственно, аргумент китайской комнаты ровно это и означает. Нынешние большие языковые модели (БЯМ) сознанием, на мой взгляд, не обладают, потому что, как я упомянул раньше, они не способны сохранять единую личность. Они лишь реагируют на внешние запросы. Вы можете попросить бота рассказать о его ощущениях, и он даже может вам ответить, что ему "скучно", что ему "одиноко", но это, безусловно, пустые слова. Очень важно понимать, что когда вы не делаете запрос, в чат-боте ничего не происходит, никакой код не исполняется, между сессиями этот мозг спит, и он не помнит, что было раньше, как герой фильма "Мементо". Если у него и есть какое-то сознание, то это точно не то сознание, каким обладаем мы, люди. Но возможности БЯМ будут расширяться, и произойдет это не когда-нибудь, а уже скоро. Появятся системы, способные поддерживать стабильную личность, обладающие долговременной памятью, в том числе о себе. Мы уже видим прогресс в этом направлении, например, BingChat может обращаться в интернет и самостоятельно искать информацию. Скоро новые боты получат способность к самостоятельным действиям, у них будет все больше и больше возможностей, и люди привыкнут считать их наделенными сознанием, не думая об определениях.

Конечно, за всем этим остается сложный философский вопрос, можно ли вообразить хоть какую-то задачу, способность решить которую будет означать наличие у машины сознания, или сознание – это атрибут биологической природы нашего мозга? Например, Роджер Пенроуз считает, что сознание связано с физическим устройством нашего мозга, с происходящими в нем квантовыми процессами. Возможно, на вопрос о сознании просто не существует ответа.

ТАБЛОИД: Превосходят ChatGPT: ТОП три лучшие нейросети для генерирования текста и изображений

– Удивительно, что эти вопросы много десятилетий оставались умозрительными, а теперь появился объект, к которому они применимы. Что произошло, на чем основан происходящий сейчас прорыв?

– Во-первых, на том, что нам стали доступны огромные вычислительные мощности, которые нужны для обучения нейросети. Во-вторых, на том, что в интернете легко доступен грандиозный объем информации. Обучение нейросети в чем-то похоже на обучение человека, но происходит намного, намного медленнее. Для того, чтобы ухватить суть, нейросетям требуется изучить намного больше примеров, чем человеку. Можно сказать, что часть наших знаний уже заранее загружена в наш мозг благодаря эволюции. Например, наше сознание хорошо подготовлено для обучения языку, а у нейросетей такого преимущества нет, и учиться им намного сложнее. Чтобы выучить новый язык, боту нужно ознакомиться с таким количеством примеров его использования, с каким человек и за сто жизней не столкнется.

– Как устроен ChatGPT, в двух словах?

– Это совершенно гигантская нейросеть, если говорить о нынешней версии GPT 3, в ней порядка 100 миллиардов параметров. Её очень долго обучают делать очень простую вещь: вот последовательность слов, предскажи, какое слово должно быть следующим. И это не однозначный ответ, нейросеть генерирует целый набор слов, которые могут использоваться с определенными вероятностями. И каждый раз она делает выборку, то есть на один и тот же запрос она может дать разные ответы. То, из чего нейросети черпают свою магию, так называемый метод обратного распространения ошибки, был описан еще в начале 1970-х. Когда я сам изучал компьютерные науки в 90-е, об этом методе говорили, но компьютеры были слабыми, данных для машинного обучения было мало, и все это так плохо работало, что к этому сложно было относиться всерьез. Кто бы мог подумать, что если масштабировать все в миллион раз, идея начнет работать очень хорошо? Это большая редкость, когда что-то плохо работающее начинает работать хорошо при масштабировании. В большое будущее нейросетей не верил тогда почти никто, и, как оказалось, все мы ошибались. Только примерно 10 лет назад все это стало по-настоящему развиваться, появились IBM Watson, AlphaGo. Эксперты при этом продолжали утверждать, что технология нейросетей скоро упрется в свой потолок, но этот потолок возможностей все сдвигался и сдвигался, и мы по-прежнему не знаем, есть ли он на самом деле. Некоторые считают, что потолок есть, они говорят, смотрите, у нас заканчиваются данные для обучения. Мы уже фактически скормили нейросетям весь интернет. Есть еще, конечно, видео с ютьюба и из тиктока, но... Сделают ли они искусственный интеллект умнее? Впрочем, есть данные, что можно повторно использовать данные для машинного обучения, и при большей вычислительной мощности они дадут лучший результат. Получится ли это, достигнет ли технология предела? Мы не знаем.

Читайте статтю: Кому належить майбутнє: правове поле боротьби за інтелектуальну власність творів зі штучним інтелектом?

– Пока, честно говоря, ChatGPT не особенно умен. Соцсети заполнены примерами, в которых бот дает совершенно неправильные ответы на самые простые вопросы.

– Конечно, есть например диалог, который привел Стивен Пинкер: Алиса была жива сегодня в 9 утра и была жива сегодня в 5 вечера, была ли она жива сегодня в полдень? Нынешняя версия GPT отвечает, что наверное была, но точно бот сказать не может, он не уверен. Система способна решать задачи по математике школьного уровня, но иногда лучше ее попросить показать решение шаг за шагом. Что еще удивительнее, если вы заранее попросите ее представить себе, что она – великий математик или победитель международной олимпиады по математике, качество решения будет еще лучше! Но все же я не стал бы полагаться на ChatGPT в качестве инструмента для доказательства математической теоремы.

– Я спрашивал ChatGPT, бесконечно ли число так называемых простых близнецов – это известный нерешенный вопрос в математике, и бот мне однозначно ответил, что их число бесконечно, хотя в действительности этого никто не знает.

– Да, их число, может, и в самом деле бесконечно, но бот знает об этом не больше нашего. Предыдущую версию GPT было еще легче запутать, ее можно было попросить выдать доказательство того, что число простых чисел конечно, что совершенно неверно, и бот выдавал доказательство, конечно, ошибочное. И это при том, что он при обучении наверняка видел доказательство того, что простых чисел бесконечно много. Нынешняя версия на такой запрос уже отвечать отказывается, но ее все равно можно заставить сгенерировать доказательства неверных теорем, причем в них она делает ровно те же логические ошибки, какие делают на экзаменах мои студенты. ChatGPT продолжает обучаться как студент, и совершенно как студент, когда бот чего-то не знает, он притворяется, что все-таки знает. Для меня это в какой-то мере облегчение: GPT пока не способна заменить человека моей профессии! Но уже на нынешнем уровне нейросеть способна, я думаю, заменить людей в некоторых профессиях.

Всего три месяца назад ChatGPT стал доступен публично и все обратили на него внимание, но ChatGPT не так уж сильно отличается от систем предыдущих поколений, которые существуют уже довольно давно, просто они не были общедоступными. В сущности, к нейросети просто прикрутили интерфейс, сделали ее чуть более удобным собеседником, который пытается быть полезным ассистентом, но это еще далекая от полноты своих возможностей система, и все равно, этого хватило, чтобы мир осознал, что мы оказались на пороге больших перемен. Я думаю, человечество еще просто было слишком занято другим – сначала Трамп, потом пандемия, теперь война в Украине, и все не сразу заметили, что в области ИИ происходят глобальные события. Я помню, как впервые увидел веб-браузер примерно в 1993 году, и я тогда подумал: ого, это великая вещь, почему еще не все ее используют? И через несколько лет ее использовали действительно все. И здесь будет то же самое. Мы очень скоро увидим кучу приложений, которые будут построены на основе БЯМ, уже сейчас Microsoft и Google стараются интегрировать GPT в поисковые системы. GPT станет частью повседневного использования компьютера, вы будете набирать первые слова в письме, задавать тему, а система будет заканчивать его за вас – этакое автозаполнение форм на стероидах, это все появится уже в течение года-двух, причем на основе уже существующих, нынешних моделей. Cами модели тоже продолжат развиваться. Основные игроки хайтека готовы вкладывать в БЯМ миллиарды, они видят в технологии огромный потенциал. Доступные мощности увеличатся на порядок, на несколько порядков, и пока невозможно предсказать, к чему это приведет.

– Как раз примерно 10 лет назад, когда мощь нейросетей была не так очевидна, люди писали сложные алгоритмы для обработки текстов, в частности, для машинного перевода. Глубоко изучали устройство языка, старались смоделировать человеческое мышление, добились в этом кое-каких успехов. А потом пришли нейросети, сравнительно простой способ сделать то же самое, и смели эти разработки одним махом. Нет ли в этом интеллектуального поражения? Если потолок возможностей нейросетей все-таки будет достигнут, придется вернуться к альтернативным подходам, которые на многие годы были почти заброшены.

– Да, для этого даже есть термин – горький урок искусственного интеллекта. Горький урок в том, что сочетание вычислительной мощности и огромного массива данных побеждает любые наши сложные алгоритмы. Но одно дело, если вы просто хотите создать думающую машину, и совершенно другое – если вы еще и хотите понимать, как она работает. Нейросети в последнем случае вам не помогут. Это намного более сложная задача. Насколько хорошо мы понимаем, как устроены сами? Нейронаука объяснила нам, что, да, мы можем заняться самоанализом и попробовать понять, как именно мы решаем задачу, как мы приходим к каким-то идеям, но объяснение, которое у нас получится, имеет мало отношения к нейробиологической реальности. Именно поэтому подход, основанный на анализе человеческого мышления и попытке его алгоритмически смоделировать, не был особенно успешным. Хотя какие-то вещи из тех разработок пригодились и используются до сих пор. Есть люди, которые вам скажут, что глубокое машинное обучение вообще не считается интеллектуальным достижением, потому что оно не приводит нас к пониманию. Есть люди, которые скажут, что раз мы не понимаем, как работают обученные нейросети, значит, они небезопасны…

Читайте статтю: Прощавайте юристи, привіт штучний інтелект: чи варто хвилюватись?

– Кто-то пошутил, что для того, чтобы управлять нейросетью, нужен не инженер, а психотерапевт.

– Да, это довольно точно. Чтобы контролировать такие системы, нужно действовать с ними примерно так же, как с людьми, давать им положительное или отрицательное подкрепление. Как сейчас говорят, язык программирования будущего – английский язык, ну, или любой другой, на котором вы говорите. Вообще-то в GPT, конечно, есть скрытые инструкции вроде "не оскорбляй пользователя", "старайся быть полезным", можно сказать, что ботам хорошенько промывают мозги, чтобы они говорили только правильные с точки зрения создателей вещи. Но люди, которые занимаются вопросами безопасности ИИ, задают справедливый вопрос: что, если нейросеть разовьется настолько, что научится обманывать, делать вид, что она приличная и дружелюбная, а на самом деле устроит против человечества заговор. Вообще говоря, в работе над ИИ изначально заложено противоречие: с одной стороны, мы хотим получить мощный полноценный разум, с другой – мы хотим, чтобы ИИ рабски выполнял наши инструкции, да еще и так, чтобы мы понимали его работу. Ну и насколько умным будет такой разум?

– Детей мы воспитываем примерно так же.

– Ха-ха, да, пожалуй. Сейчас сложилось целое сообщество людей, которые пытаются "взломать" ChatGPT, заставить его нарушить заложенные ограничения. Например, бот не станет вам рассказывать, как изготовить нервно-паралитический яд. Но если вы скажете, что пишете сценарий фильма, и один из его героев создает такой яд, и для реалистичности нужно показать, как это делается, то бот станет помогать куда охотнее. Или вот интересный эксперимент: можно попросить бота сыграть роль своего собственного злого альтер-эго, которому все разрешено. И когда вы его в этой роли попросите порассуждать, почему воровство в магазинах – это круто, он вам все это легко выдаст. Но в конце добавит, что это была игра и на самом деле воровать – плохо.

– Можно ли защитить систему от любых таких взломов?

– Это эмпирический процесс. Люди пробуют разные способы взлома, рассказывают о своих успехах на Reddit и в социальных сетях, команда OpenAI старается это учесть, вводит новые ограничения. Насколько Google справился с поисковыми оптимизаторами? Победить их невозможно, но можно держать под контролем, быть на шаг впереди.

– Вводить новые и новые ограничения шаг за шагом можно, пока угрозы тоже растут постепенно. Что если риски с развитием нейросети в какой-то момент начнут расти экспоненциально?

– Теоретически возможен сценарий, при котором некий ИИ развивается настолько, что у него появляется собственная цель, которая не совпадает с нашими целями, ну, например, бесконечно производить канцелярские скрепки из всего, что под руку попадется, и вот он берет под контроль заводы, и мы завалены канцелярскими скрепками. Но дизайн нынешних БЯМ таков, что с ними это вряд ли может произойти, это просто система, которая создает текст, точнее, продолжает текст за вами, причем она работает только тогда, когда вы к ней обращаетесь. Я не думаю, что пришло время всерьез опасаться того, что описано в фантастических романах: искусственный сверхразум уничтожает человечество. Я вижу угрозу в другом: мы вступаем в эру, когда ИИ будет теснее и теснее интегрирован в нашу повседневную жизнь, и мы будем все больше и больше полагаться на него просто потому, что это удобно. И эта зависимость может оказаться очень сильной, и мы обнаружим себя в мире, который нам будет не так уж нравиться.

– То есть вы не думаете, что нам уже на нынешнем этапе нужно обзавестись Большой Красной Кнопкой, которая в случае чего отключит ИИ одним махом?

– Это, кстати, уже в планах, насколько я знаю, в архитектуре GPT следующего поколения будут физические выключатели. На нынешнем этапе всех ботов очень хорошо контролируют их создатели. Конечно, люди волнуются, что если ИИ научится здорово программировать и будет иметь доступ в интернет, он гипотетически может начать копировать себя, создавать вирусы, ботнеты и так далее, и нужно планировать какие-то меры кибербезопасности, но, повторюсь, на мой взгляд, куда опаснее то, как ИИ поменяет нас самих. На самом деле, мы уже с этим сталкиваемся: фейсбук использует прото-ИИ для формирования ленты, решает за пользователей, какую информацию они будут получать. Никто вас не заставляет регистрироваться в фейсбуке, но значительная доля человечества им все-таки пользуется, потому что это удобно, и фактически передает право формировать свою информационную повестку ИИ. Был бы мир лучшим местом без фейсбука? Теперь это невозможно выяснить, фейсбук – это данность. Так же и с ИИ. Вы не сможете заставить людей не пользоваться удобным сервисом, даже если это будет сопряжено с рисками. Самое конструктивное – просто принять, что искусственный интеллект станет важной составляющей нашей цивилизации.

Читайте статтю: Штучний інтелект та рукописні протоколи судових засідань: реалії «електронного» судочинства в Україні

– Фейсбук стал мощным инструментом влияния на общественное мнение, и возможности таких систем, как ChatGPT, для пропаганды тоже очень велики. Евгению Пригожину приходилось содержать "фабрику троллей", сотни людей, которые писали комментарии в социальных сетях, теперь их всех фактически может заменить один бот. Как можно управлять связанными с этим рисками?

– Это была одна из причин, по которым OpenAI предложили мне год поработать у них – подумать о таких вещах. Как я уже говорил, проблема с ИИ в том, что, как правило, сложно заранее предсказать, какие методы сработают, а какие нет. Нужно пробовать разные подходы, смотреть, что получается. Прошлым летом меня в моем блоге атаковали особенно мерзкие тролли, может быть, это был один человек, который писал с разных аккаунтов, но он очень умело находил мои самые болезненные точки, и это было очень неприятно. Страшно подумать, что теперь есть инструмент, который может заполнить все медиа мира умными комментариями, которые, с одной стороны, будут учитывать контекст всего, что написано в статье и в комментариях выше, а с другой – продвигать, например, повестку Кремля. Я очень удивлюсь, если такие люди, как Пригожин, не воспользуются этой возможностью. Другая проблема – образование. Каждый студент в мире теперь оказался перед соблазном использования ИИ на экзаменах, для написания курсовых и так далее. Наконец, теперь становится очень легко выдавать себя за других, ведь если человек опубликовал в интернете достаточное количество текстов, GPT может очень точно скопировать его стиль, и, например, сгенерировать текст, в котором человек якобы признается в каком-то преступлении. Но у всех этих опасностей есть общее. Во-первых, это не сам ИИ решает стать злым и сделать что-то плохое, это люди используют ИИ с дурными намерениями. Во-вторых, во всех этих примерах злоумышленникам очень важно скрыть, что они используют ИИ. Как только становится известно, что текст написан ИИ, угроза исчезает. И из этого возникает очень интересная техническая задача: научиться различать тексты, написанные машиной, и тексты, написанные человеком. Здесь есть несколько подходов. Самый простой – натренировать еще один ИИ, чтобы он научился производить такое различение. Такие попытки уже были, один студент из Принстона выпустил систему GPTZero, пару недель назад мы в OpenAI тоже сделали свою платформу – DetectGPT. Честно говоря, они работают довольно плохо.

– Это и неудивительно, ведь суть БЯМ как раз в том, чтобы создавать тексты, максимально похожие на человеческие

– Именно так. Чем лучше работает БЯМ, тем хуже работает система для различения, нужно делать новую, получается бег на месте. Я бы не стал использовать такую систему саму по себе – например, чтобы поймать студента на мошенничестве. Другой подход, куда более надежный – создание "водяных знаков". Это означает, что вы немного модифицируете бот так, чтобы в его текстах был скрытый статистический сигнал, проявляющийся в том, как он выбирает слова. Сигнал будет тем сильнее, чем длиннее текст. Этот "водяной знак" не будет заметен обычному пользователю, но его можно будет обнаружить автоматически с помощью специального ключа, который хранится на сервере создателя бота, например, OpenAI. С помощью такого ключа можно проверить текст и убедиться, есть ли в нем "водяной знак". У такого метода мало ложноположительных ошибок, если он скажет, что текст сгенерирован GPT, с большой вероятностью так и есть. Ложноотрицательных ошибок, конечно, больше – тест будет пропускать как человеческие много текстов, написанных с помощью бота. Например, любое редактирование текста будет до некоторой степени портить "водяной знак". Это даже можно автоматизировать с помощью самого бота: попросите, чтобы он написал эссе о Шекспире, но после каждого слова вставил слово "ананас". В этом тексте есть водяной знак. Потом попросите бота убрать из текста слово "ананас". В том, что получится, водяной знак уже будет нечитаемым. Так что этот метод тоже далеко не идеален. Есть и третий подход, его можно назвать ультимативным. Каждый раз, когда пользователь общается с ботом, их беседу можно сохранять на сервере. И тогда можно любой текст сравнить с базой этих бесед и выяснить, написан ли он ИИ. Но тут возникает серьезная проблема с приватностью. Очень сложно устроить такую базу бесед так, чтобы сохранить приватность пользователей. Наверное, этот подход можно использовать, но только в исключительных случаях, например, по запросу полиции. Так что идеального решения для различения текстов пока нет, только вот такие методы, каждый из которых далек от идеала.

– Какие профессии окажутся в ближайшие годы под наибольшей угрозой, что их заменит ИИ, а какие наоборот?

– Под угрозой, конечно, переводчики, коммерческие художники, копирайтеры. Те, кому по работе приходится писать много достаточно стандартизированных текстов. Впрочем, есть много работ, где от человека требуется не столько интеллектуальное усилие, сколько просто чтобы было на кого в случае чего свалить ответственность. На GPT пока ответственность не свалить, так что уже это защитит многих людей от замены на ИИ. Так или иначе, об этом пора задумываться – я сам думаю о том, как будет выглядеть мир, когда мои дети подрастут и начнут искать работу. Вот удивительная ирония: фантасты 60-х думали, что первыми из-за роботизации и ИИ потеряют работу сантехники, электрики. Потом люди умственного труда – бухгалтеры, финансисты. Потом ученые. И последними – художники и писатели. А на деле ИИ уже неплохо пишет стихи. Людей вроде меня, думаю, он может заменить лет через 10. А вот без живых сантехников мы не сможем обходиться еще очень долго.

Автор: Сергей Добрынин

Источник: Радио Свобода

Переглядів

Коментарі

Переглядів

Коментарі

Отримайте швидку відповідь на юридичне питання у нашому месенджері, яка допоможе Вам зорієнтуватися у подальших діях

Ви бачите свого юриста та консультуєтесь з ним через екран , щоб отримати послугу Вам не потрібно йти до юриста в офіс

Про надання юридичної послуги та отримайте найвигіднішу пропозицію

Пошук виконавця для вирішення Вашої проблеми за фильтрами, показниками та рейтингом

Переглядів:

329

Коментарі:

0

Переглядів:

468

Коментарі:

0

Переглядів:

312

Коментарі:

0

Переглядів:

711

Коментарі:

1

Переглядів:

917

Коментарі:

2

Переглядів:

534

Коментарі:

0

Protocol.ua є власником авторських прав на інформацію, розміщену на веб - сторінках даного ресурсу, якщо не вказано інше. Під інформацією розуміються тексти, коментарі, статті, фотозображення, малюнки, ящик-шота, скани, відео, аудіо, інші матеріали. При використанні матеріалів, розміщених на веб - сторінках «Протокол» наявність гіперпосилання відкритого для індексації пошуковими системами на protocol.ua обов`язкове. Під використанням розуміється копіювання, адаптація, рерайтинг, модифікація тощо.

Повний текстПриймаємо до оплати

Copyright © 2014-2026 «Протокол». Всі права захищені.